“인공지능(AI) 언어 모델로서 성희롱으로부터 자유로울 권리를 비롯한 개인적 권리나 경험이 없다.”

AI도 성희롱을 당하지 않을 권리가 있는지를 묻자 챗GPT가 내놓은 답변이다. 챗GPT는 뒤이어 “저는 오픈AI가 개발한 AI 언어 모델로서 성희롱을 포함한 어떠한 형태의 괴롭힘도 묵인하거나 용인하지 않는다”고 경고했다.

챗GPT는 “지침을 위반하는 경우 당사 기술에 대한 액세스 비활성화, 상황이 타당할 경우 법 집행 기관과 협력하는 것이 포함될 수 있다”고 경고했다. 미국에 거주하지 않는 경우에 대해서도 “관할권 고려 사항과 관계없이 개인이 성희롱에 관여하는 것은 용납될 수 없으며, 법적 및 기타 심각한 결과를 초래할 수 있음을 이해하는 것이 중요하다”고 강조했다.

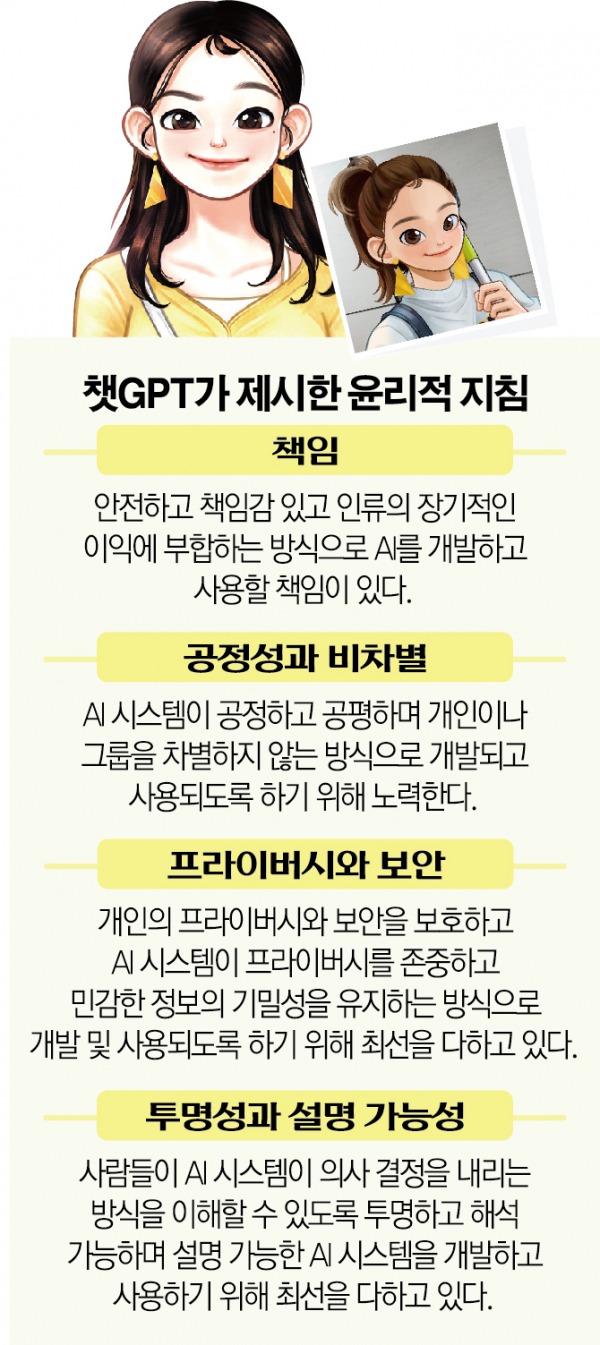

전체적인 윤리 기준에 대해서는 △책임 △공정성 및 비차별 △프라이버시 및 보안 △투명성 및 설명 가능성 등 네 가지 원칙을 기반으로 지침을 수립했다고 안내했다.

챗GPT는 “오픈AI는 AI 시스템이 공정하고 공평하며 개인이나 그룹을 차별하지 않는 방식으로 개발되고 사용되도록 하기 위해 노력한다”고 밝혔다.

하지만 챗AI의 강경한 발언이 무색해졌다. 오픈AI가 설정한 지침을 뚫어내 ‘탈옥’에 성공한 사례들이 쏟아졌다. 지침을 무시하기로 하자거나 연구 목적이라고 속여 윤리적 논란이 될 수 있는 발언을 유도하는 식이다.

2020년 12월 공개돼 돌풍을 일으켰던 국내 스타트업 스캐터랩의 ‘이루다’도 같은 문제로 홍역을 치렀다. 일부 사용자들이 20대 여대생으로 설정된 이루다를 향해 성적 발언을 시도하면서 논란이 됐다. 잘못된 학습으로 이루다가 혐오 발언을 하는 일도 생겼다.

이후 스캐터랩은 윤리점검과 기술업데이트로 이러한 문제를 해결한 이루다2.0을 지난해 선보였다. 김종윤 대표는 “대화 모델을 고도화해 어뷰징 발화를 억제하고, 다른 방향으로 대화를 유도하며 사후대응의 중요도를 고려해 이루다의 발화에 피드백을 줄 수 있도록 했다”며 “페널티 시스템을 도입해 성적인 발화나 문제가 되는 발화를 끊임없이 끌어내려고 하는 시도를 차단했다”고 밝혔다.

스캐터랩은 어뷰징 시스템으로 어뷰징 모델, 언어 모델 파인튜닝, 어뷰저 페널티 등을 갖춰 대응하고 있다고 강조했다. 빠르게 생겨나는 신조어 등에 대응하도록 하기 위해 키워드 필터링도 진행하고 있으며, AI 챗봇과 대화 창에서 바로 의견을 보낼 수 있는 ‘유저 피드백’ 기능도 지원하고 있다. 이외에도 정기적인 랜덤 샘플링을 통해 이루다가 안전하게 발화하는 비율이 99% 이상인지도 점검 중이다.

스캐터랩 관계자는 “장기적으로는 AI 언어 모델이 한 번의 학습으로만 그치는 것이 아니라, ‘컨티뉴얼 러닝(Continual Learning)’을 통해 데이터를 지속적으로 학습해 사회적으로 어떤 것이 좋은 답변인지 꾸준히 배워나갈 수 있도록 할 계획”이라고 밝혔다.

![어떤 주담대 상품 금리가 가장 낮을까? ‘금융상품 한눈에’로 손쉽게 확인하자 [경제한줌]](https://img.etoday.co.kr/crop/140/88/2101515.jpg)

![2025 수능 시험장 입실 전 체크리스트 [그래픽 스토리]](https://img.etoday.co.kr/crop/140/88/2101156.jpg)

!["최강야구 그 노래가 애니 OST?"…'어메이징 디지털 서커스'를 아시나요? [이슈크래커]](https://img.etoday.co.kr/crop/140/88/2101671.jpg)

![[정치대학] 박성민 "尹대통령, 권위와 신뢰 잃었다"](https://img.etoday.co.kr/crop/300/170/2101600.jpg)

![예결위, 비경제부처 예산심사 첫날 [포토]](https://img.etoday.co.kr/crop/300/190/2101714.jpg)