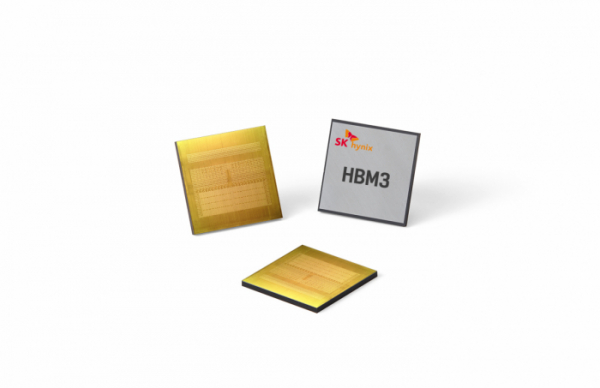

2013년 업계 최초로 HBM(고대역폭 메모리)을 개발한 SK하이닉스는 지난해 6월 4세대인 HBM3를 양산했다. HBM3는 이전 세대인 HBM2E보다 처리 속도가 78% 빨라졌다. 풀HD급 영화 163편을 1초에 전송하는 최대 819GB(기가바이트)의 속도를 구현했다.

HBM은 여러 개의 D램을 수직으로 연결한 3D 형태의 메모리반도체로 데이터를 빠르게 전송하는 장점이 있다. 방대한 데이터를 처리해야 하는 AI, 서버용 시장에서 주목받고 있다.

최근 글로벌 빅테크 기업들은 AI 등 첨단기술의 발전 속도가 빨라지면서 급격하게 늘어나는 데이터를 빠르게 처리하는 데 고심하고 있다. 데이터 처리 속도와 성능을 기존 D램 대비 현격히 높인 HBM은 최적의 제품으로 평가받고 있다.

SK하이닉스는 그래픽처리장치(GPU) 업계 1위 엔비디아의 ‘A100’과 ‘H100’ 칩셋에 HBM을 공급한다. 엔비디아는 H100에 HBM3을 결합해 AI, 슈퍼컴퓨터 등으로 사용 범위가 확대되는 가속컴퓨팅 분야에 공급하고 있다.

HBM은 고부가가치 제품이라는 점에서 시장이 확대될수록 수익성이 커진다. 업황 부진으로 고전하고 있는 반도체 업계에는 분위기를 뒤집을 수 있는 미래 먹거리로 자리 잡았다.

박정호 SK하이닉스 부회장은 15일 서울 광화문 프레스센터에서 열린 한림대 도헌학술원 개원 기념 학술심포지엄 기조연설에서 “AI 시대에 일어날 기술 혁신의 중심에는 항상 메모리 반도체가 있을 것”이라며 “앞으로 AI 챗봇 분야가 반도체 수요의 새로운 ‘킬러 애플리케이션’이 될 가능성이 크다”고 밝혔다.

이어 “챗GPT 등 AI 시대가 펼쳐지고 관련 기술이 진화하면서 글로벌 데이터 생성, 저장, 처리량은 기하급수적으로 늘어날 것”이라며 “이러한 흐름 속에 SK하이닉스가 세계 최초로 개발한 최고속 D램인 HBM은 AI 시대 기술 진화에 큰 역할을 하고 있다”고 강조했다.

SK하이닉스 관계자는 “연말부터 HMB3가 고객사에 본격적으로 공급되기 시작했다”며 “제품 개발 로드맵을 구체적으로 밝힐 수는 없지만 차세대 모델 개발도 꾸준히 진행 중인 것으로 안다”고 말했다.

![어떤 주담대 상품 금리가 가장 낮을까? ‘금융상품 한눈에’로 손쉽게 확인하자 [경제한줌]](https://img.etoday.co.kr/crop/140/88/2101515.jpg)

![2025 수능 시험장 입실 전 체크리스트 [그래픽 스토리]](https://img.etoday.co.kr/crop/140/88/2101156.jpg)

!["최강야구 그 노래가 애니 OST?"…'어메이징 디지털 서커스'를 아시나요? [이슈크래커]](https://img.etoday.co.kr/crop/140/88/2101671.jpg)

![[찐코노미] 美 취약점을 파고든 K방산의 미래…차기 방산 대장주는 '이것'?](https://img.etoday.co.kr/crop/300/170/2101653.jpg)

![예결위, 비경제부처 예산심사 첫날 [포토]](https://img.etoday.co.kr/crop/300/190/2101714.jpg)